6. Dropout(丢弃法)

6. Dropout(丢弃法)

-

动机

- 一个好的模型需要对输入数据有抗扰动鲁棒性。

- 使用带噪声的数据等价于Tikhonov正则(L2正则),是一种正则化手段。

- Dropout的本质:在神经网络的层与层之间随机加入噪声。

-

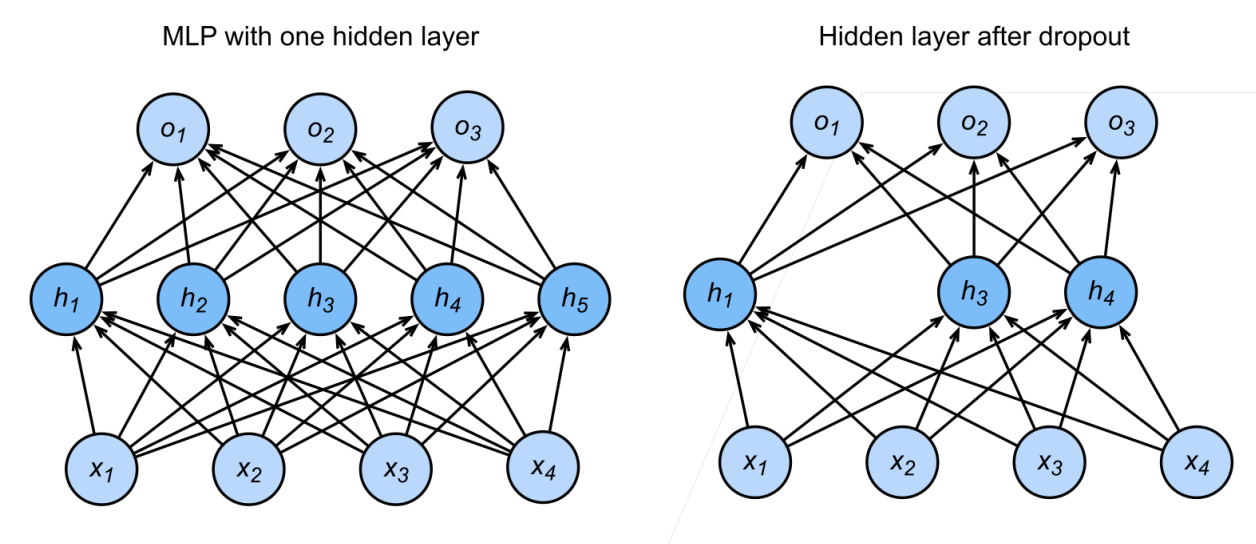

Dropout的实现方式

- 对输入

加噪声得到 ,要求 ,保证无偏性。 - Dropout对每个元素进行如下扰动(丢弃概率

):

- 对输入

- Dropout的应用

- 通常将Dropout用在多层感知机(MLP)的隐藏层输出上。

- 前向传播流程:

-

推理/预测时的Dropout

- 正则项只在训练时起作用,推理阶段不用丢弃,而是直接返回输入(保证输出确定性)。

- 预测时:

实际上就是 本身。

-

总结

- Dropout将一些输出项随机置0,以抑制模型复杂度,防止过拟合。

- 多用于神经网络的隐藏层。

- 丢弃概率

是控制模型复杂度的超参数,一般要通过验证集调优。

记住,Dropout不是随便用的,每层、每种任务的

一般都要调参。训练和推理阶段Dropout行为不同,这点别混了!

参考资料

“觉得不错的话,给点打赏吧 ୧(๑•̀⌄•́๑)૭”

微信支付

支付宝支付

6. Dropout(丢弃法)

http://neurowave.tech/2025/04/22/10-6-LNN-Dropout/